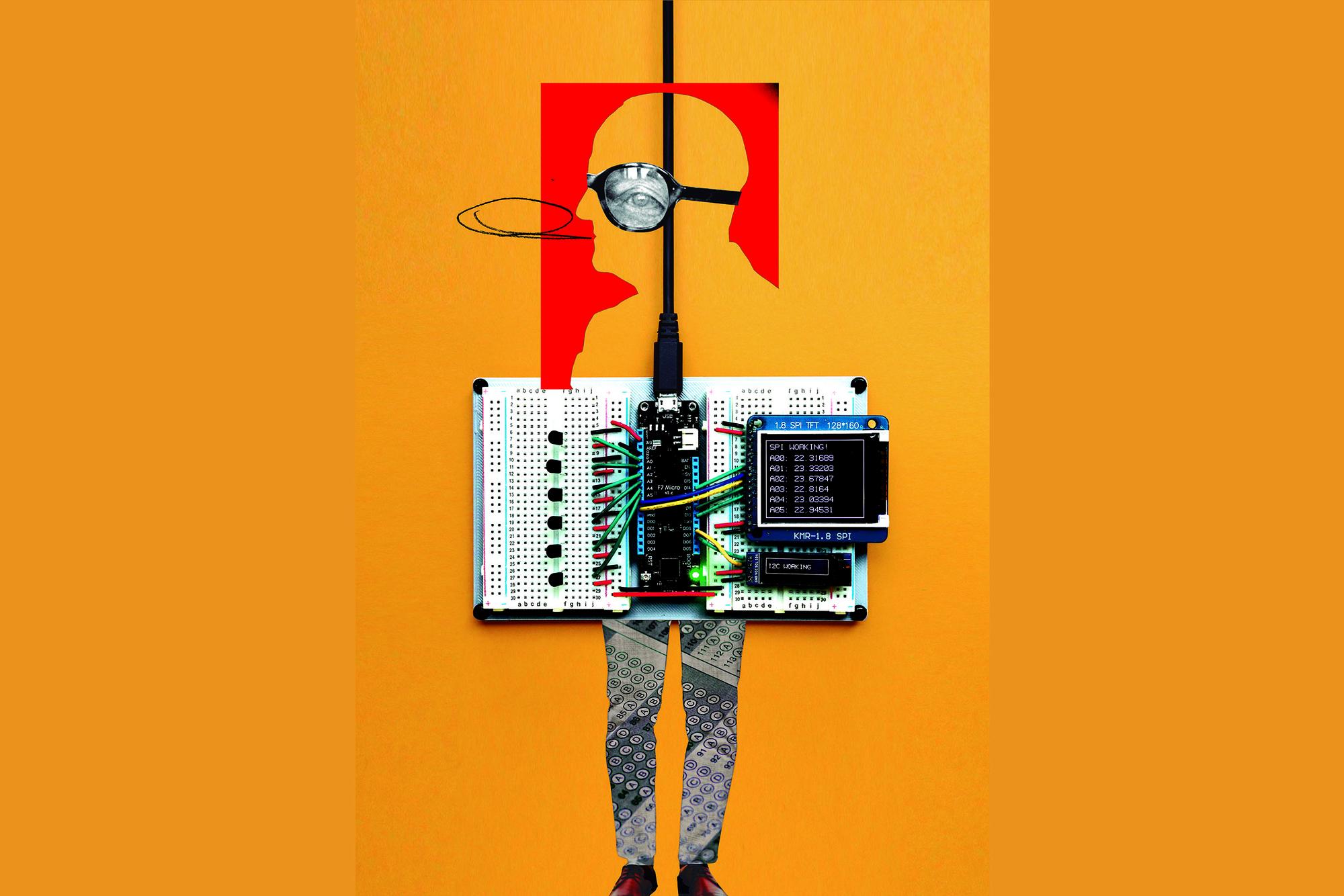

Imagen de portada realizada por Patricia Bolinches

Artículo original publicado elsaltodiario.com en por Pablo Elorduy

Solo unas horas después de sacar adelante la primera ley sobre economía digital, la Parlamento Europeo aprobaba la primera Directiva sobre Inteligencia Artificial. Con 523 votos a favor, 46 en contra y 49 abstenciones, la norma supone un cambio de paradigma respecto al escenario de completa desregulación anterior. La ley votada el 13 de marzo entrará en vigor en mayo y su implementación por parte de los Gobiernos nacionales se espera para 2026. Esta ratificación no es un simple trámite, sino que los distintos Estados miembro pueden establecer sus propios límites y recortes en las obligaciones que dibuja el tratado.

En la presentación del texto Brando Benifei (S&D, al que pertenece el PSOE) celebró como una “jornada histórica” la luz verde a una norma que comenzó a estudiarse antes de la llegada de Chat GPT —el juguete algorítmico más conocido de los últimos tiempos— y que se aplicará sobre productos que aún no han sido concebidos. Los principales partidos europeos tenían un objetivo: ser los primeros en regular la inteligencia artificial. Se trata de encontrar una serie de normativas que influyan sobre las predicciones, recomendaciones o decisiones que ya son capaces de realizar las máquinas a través de la acumulación de datos.

El hecho de que no exista una normativa anterior, y que no haya otra institución internacional que haya implementado todavía una directiva de este tipo, invita a pensar que, a pesar de sus limitaciones, la propia existencia de la Ley IA es una buena noticia. Como señala Sofía Scasserra, investigadora Asociada al Transnational Institute, este sector ha crecido en un contexto de monopolización del mercado en una internet desregulada. Los primeros impactos negativos de la digitalización apenas fueron atendidos por los Estados nacionales, que se situaban de espaldas a unas prácticas “por conveniencia o por desconocimiento”, resume Scasserra.

Entre los puntos negativos de la ley está que se otorga a las empresas la capacidad de definir qué aplicación de la IA será considerada de alto riesgo y cuál no

Pero, a medida que ha crecido el negocio, el poder, y el impacto en la vida cotidiana de la gente de los productos diseñados por estas empresas, se ha llegado a un consenso —al menos en la Unión Europea— para encauzar las prácticas de las grandes del sector, las llamadas big tech, dentro del marco de normas de la competencia.

La norma establece cuatro niveles de riesgo, en el que se basará la aprobación de programas. Del inaceptable, que prohíbe la aprobación de sistemas de crédito social, de vigilancia masiva o amenazas a la seguridad al “alto riesgo” o al riesgo mínimo de usos “inocuos”. Pero la Ley deja fuera las competencias de los Estados miembros en materia de seguridad nacional, con lo cual abre diversas vías para puertas traseras que pueden aumentar los riesgos derivados de su uso. Pese a que reconocen aspectos que mejoran la situación actual, partidos como Podemos (dentro de The Left en el Parlamento Europeo) han votado en contra. “Tal y como se ha aprobado”, indican fuentes de la formación morada, la ley “antepone los intereses de las grandes tecnológicas a la protección de la ciudadanía y sus derechos fundamentales, especialmente la privacidad y la no discriminación”.

El poder del valle de silicio

El proceso de preparación de la norma ha estado definido por el trabajo de zapa de los lobbies de la inteligencia artificial. Un informe publicado el 11 de marzo por Corporate Europe Observatory (CEO) ha detallado el intenso trabajo llevado a cabo por los gigantes del sector y por dos proyectos de raíz europea, la francesa Mistral AI y la alemana Aleph Alpha, para orientar la directiva a sus intereses.

En 2023, último año con registros completos, el 78% de las reuniones de eurodiputados para abordar las problemáticas de la inteligencia artificial fueron con representantes de compañías. Google y Microsoft, especialmente, pero también Spotify, Uber, Amazon o Netflix se han interesado por contactar con distintos parlamentarios para trasladarles sus preocupaciones.

Las negociaciones han estado definidas por dos posiciones, una, a favor de una regulación laxa, basada en que una norma con demasiados controles podía poner “en peligro la competitividad y la soberanía tecnológica de Europa” —en palabras de una carta abierta firmada por 150 empresas—. La otra, basada en el hecho de que la falta de regulación puede incrementar las dificultades asociadas al uso de la inteligencia artificial. Un amplio abanico de problemas que va desde los problemas de autoría en la creación cultural, el uso intensivo de energía o su empleo en la vigilancia fronteriza.

Según han denunciado ONG como CEO o el Observatoire des Multinationales (ODM), la legislación aprobada favorece en particular a las grandes tecnológicas de Silicon Valley, que han desarrollado en esta década los principales motores de aprendizaje automático. Gemini, el modelo de lenguaje multimodal de Google, Titan, el de Amazon, o ChatGPT, desarrollado con la financiación de Microsoft, son las triunfadoras de un modelo económico que tiende al monopolio y que, aunque está plagado de pequeñas compañías y startup, sigue una particular ley del embudo por el que el rastro del dinero siempre llega a Palo Alto (California), centro de operaciones del capitalismo GAFAM (acrónimo de Google, Apple, Facebook, Amazon y Microsoft).

Cathy O’Neil, que ha criticado los usos del Big Data para la toma de decisiones políticas, explicaba una de las características fundamentales de estos modelos: “Suelen castigar a los pobres”

“Sin embargo”, señala el informe de CEO, “fue el lobby de la startup francesa Mistral AI y de la startup alemana Aleph Alpha lo que inclinó la balanza”. Ambas empresas, favorecidas por ser de la “marca Europa” han tenido acceso a las instancias más altas de toma de decisiones, Pero, como explican desde el propio observatorio, las huellas vuelven a llevar al valle californiano del Silicio. El periodista tecnológico Luca Bertuzzi, detallaba en un hilo de Twitter cómo Mistral IA ha hecho el trabajo sucio para las grandes tecnológicas, en gran medida después del acuerdo que esta compañía firmó en febrero de 2023 con Microsoft, que aporta 15 millones de euros al desarrollo de sus productos y cederá sus servidores para el entrenamiento y la distribución de sus modelos.

Entre los puntos negativos de la ley está que se otorga a las empresas la capacidad de definir qué aplicación de la IA será considerada de alto riesgo y cuál no. Desde Podemos se estima que la definición de alto riesgo “es muy vaga y para todos los usos prohibidos de la IA se establecen excepciones, que son enormes puertas traseras”. La evaluación de impacto sobre los derechos de la ciudadanía que incluye la ley solo se aplicará a las instituciones públicas, mientras que a las empresas que usen esta tecnología únicamente se les anima a adherirse a esos criterios, “sin obligarles a cumplirlos”, recalcan desde este partido de la izquierda europea.

“Debería haber mecanismos de control más allá de la Ley IA, que es un buen primer intento pero es totalmente insuficiente”, resume Scasserra. Se refiere, por ejemplo a las posibles pérdidas de empleos que pueden acarrear estas tecnológicas. En marzo de 2023, solo un año después del lanzamiento de ChatGPT, el banco Goldman Sachs lanzó la estimación de que 300 millones de empleos en todo el mundo —el 18% del total— pueden desaparecer como consecuencia de la expansión de la Inteligencia Artificial. Los trabajos amenazados son los considerados de cuello blanco: puestos administrativos, también en el ámbito de la Justicia, traductores e intérpretes, y también profesionales de la ilustración, artistas, periodistas, publicistas… y profesionales de la programación informática.

El abanico de problemas

En diciembre de 2022, un escándalo sacudió el panorama político australiano. El sistema de asistencia social había notificado por error a 430.000 beneficiarios que tenían una deuda. El plan llevado a cabo por el Gobierno de Scott Morrison se basaba en la presunción de sospecha sobre decenas de miles de personas perceptoras de ayudas. Se cruzaron los datos de ingresos con los de Hacienda y se hicieron sin una investigación humana, solo a través de un modelaje algorítmico. Las respuestas de los ciudadanos que eran conscientes del error y de cómo este estaba arruinando sus vidas caían en un saco roto: la máquina no atendía a razones —no estaba programado para ello— y las altas instancias políticas que la habían puesto en marcha confiaban en ella en su particular guerra contra los pobres. El escándalo de Robodeuda costó vidas humanas —suicidios y deterioro de la salud por la ansiedad provocada por la situación— y 1.800 millones de dólares australianos en indemnizaciones al Gobierno aussie.

No es el único caso en el que la robotización de procesos y el empleo del Big Data han sido un fiasco para las administraciones y una maquinaria de sufrimiento para sus damnificados. En enero de 2021, el Gobierno de Países Bajos dimitió al completo como consecuencia de un escándalo similar. En aquella ocasión, las víctimas eran perceptoras de prestaciones de cuidado infantil. La máquina había empleado un mecanismo de autoaprendizaje que clasificaba perfiles de riesgo de posible fraude. Como consecuencia, el Gobierno emitió multas, un millar de niños y niñas fueron a parar a familias de acogida —separados de sus progenitores— y se repitieron parecidas tragedias: suicidio, problemas de salud mental derivados de la política de discriminación y la confirmación de una situación de racismo institucional que separa a ciudadanos de primera y candidatos a la marginación y la exclusión social.

El tratamiento de datos personales y el derecho a la privacidad son los principales agujeros de un ramillete que se extiende en todas direcciones. La investigadora estadounidense Cathy O’Neil que, con su Armas de Destrucción Matemática (Capitán Swing, 2018), abrió el camino de la crítica hacia los usos del Big Data para la toma de decisiones políticas, explicaba en este libro una de las características fundamentales de estos modelos: “suelen castigar a los pobres”. Y el castigo se aplica en distintas esferas: a la hora de encontrar un empleo —selección automatizada de perfiles—, de percibir ayudas, acceder a becas, perder el derecho a un juicio justo, y hasta de ser seleccionado como un perfil proclive a cometer delitos por parte de software de control de riesgos de tipo “minority report”.

Sofía Scasserra subraya que la cuestión de los sesgos no es el único punto problemático, ni siquiera la cuestión fundamental ya que, razona, ninguna empresa quiere verse asociada a la publicidad negativa que dan las acusaciones de discriminación. Hay, además un problema de acceso y de diseño: no es lo mismo el uso que alguien con cierta formación educativa puede realizar de un programa como Chat GPT que alguien que no está en ese nivel. Esa barrera de entrada es una vía hacia la desigualdad desde la etapa escolar: no es lo mismo un hogar en el que determinadas tareas se pueden hacer con esa u otras herramientas a otros donde no se conocen sus posibles usos, o una escuela en la que el personal está familiarizado con ese software a otras en las que ni siquiera hay computadoras. En otros casos, el diseño por parte de las start-up puede influir en el urbanismo: semáforos que fijan el tiempo de paso de peatones según la velocidad promedio de los viandantes pueden acarrear dificultades añadidas a personas con problemas de movilidad, ancianos o que acostumbran a ir más cargadas.

“La Ley de IA conducirá al uso de tecnologías digitales de formas nuevas y dañinas para apuntalar la Europa Fortaleza y limitar la llegada de personas vulnerables en busca de seguridad”, dicen desde Statewatch

En 2016 nació la Liga de la Justicia Algorítmica, activa hasta el día de hoy, que tiene entre sus objetivos sensibilizar y denunciar sobre los sesgos, de raza, de género y de clase, que se aplican en esos algoritmos. También alertan de la pérdida de un derecho fundamental como es el de la privacidad derivada del uso de los sistemas biométricos de vigilancia.

Precisamente este es uno de los puntos más oscuros de la nueva ley aprobada en el Parlamento Europeo: la ley no prohíbe el uso de la inteligencia artificial en el contexto de la vigilancia fronteriza o en la gestión migratoria, ni el reconocimiento biométrico a través de material grabado. Chris Jones, director ejecutivo de Statewatch, que monitoriza las normas y prácticas de vigilancia y restricción de derechos, reaccionaba así ante la aprobación de la Ley: “La Ley de IA puede ser una ley nueva, pero encaja en una historia mucho más antigua en la que los gobiernos y agencias de la UE —incluyendo Frontex— han violado los derechos de los migrantes y refugiados durante décadas. Implementada junto con una serie de nuevas leyes restrictivas de asilo y migración, la Ley de IA conducirá al uso de tecnologías digitales de formas nuevas y dañinas para apuntalar la ”Europa Fortaleza“ y limitar la llegada de personas vulnerables en busca de seguridad”.

En junio, durante la discusión de la Ley en el Parlamento Europeo, el grupo de The Left consiguió que se prohibiera el uso de ese software de reconocimiento biométrico en tiempo real, pero este mes de marzo, la ley se ha endurecido, incluyendo varias excepciones que lo permiten. La vigilancia biométrica en remoto no ha sido catalogada como “riesgo inaceptable” y ha sido encuadrada en el segundo nivel de “riesgo alto”, cuyo uso está permitido sujeto a requisitos.

Desde Podemos se detalla que tampoco se regula el uso de la IA en el ámbito policial, “por lo que podrá ser comercializada en la UE, abriendo la puerta a su uso para la aplicación de sistemas de reconocimiento de emociones o detectores de mentiras”. Además, no se cierra la aplicación en sistemas de “predictive policing” que busca aplicar la IA a la predicción de la comisión de crímenes, “algo que ya aplican países como Alemania o Francia, mientras que otros como España están estudiando su posible uso”, señalan desde la formación morada.

En la actualidad se estima que los data centers consumen un 2% del total de la energía mundial, aunque el incremento es geométrico

Escándalos como el de Cambridge Analytica serán vistos como la prehistoria de otra práctica que utiliza la inteligencia artificial para seguir extendiéndose: la manipulación política. El pasado mes de febrero Open AI —creadora de ChatGPT, propiedad entre otros de Elon Musk y Microsoft— lanzó Sora. Sora promete ser la herramienta de vídeo definitiva, capaz de generar escenas complejas a partir de una pequeña descripción por parte del usuario. Pero los expertos indican que este tipo de entornos son especialmente proclives para la intoxicación en campañas electorales a través de imágenes, audio o vídeos engañosos. Los datos personales que se vuelcan en internet son el material de partida con el que se trabaja para la elaboración de perfiles y su uso en campañas para generar simpatías, antipatías o hastío, según el arquetipo generado y explotado por la máquina. El Centro para Contrarrestar el Odio Digital ha alertado de la nueva dimensión que Sora y procesadores similares dan a una práctica como la de deep fake —”creación” o suplantación digital de personas— usada ya en contexto electoral y, también, extraordinariamente dolosa en su utilización para la generación de pornografía.

El uso de la Inteligencia Artificial ya está totalmente extendido también en la guerra, singularmente a través de los drones. Un artículo reciente de Foreign Affairs ha señalado que el ejército de EE UU usa la IA literalmente “para todo”: para mantener equipos, asignaciones presupuestarias, y hasta la predicción de la invasión rusa de Ucrania en 2022. En el capítulo de riesgos se señala que las IA son utilizadas en ejecuciones extrajudiciales —con o sin errores en la localización de objetivos— o serán capaces de, por ejemplo, sintetizar nuevas armas biológicas. Se advierte también de las “cajas negras” que impiden saber en qué se basan las decisiones tomadas por la inteligencia artificial y de riesgos como que las IA engañen a otras de su especie para instarlas, por ejemplo, a bombardeos no deseados de infraestructuras civiles.

Junto a los problemas de su uso en la restricción de derechos, y a los traumas que ya han generado distintos tipos de software en materia de políticas públicos, otra de las cuestiones no resueltas en la norma tiene que ver con los efectos sobre el clima que ya está teniendo su aplicación masiva y se refiere a la cantidad de energía que gastan los motores basados en el Big Data. Estos centros, por ejemplo, toman el 20% de la energía total que se consume en Irlanda, uno de los destinos prioritarios de las big tech en Europa. En la actualidad se estima que los data centers consumen un 2% del total de la energía mundial, aunque el incremento es geométrico. A nivel global, un informe de la Agencia Internacional de la Energía (IAE) ha calculado que la necesidad de consumo se duplicará desde 2024 hasta 2026. La ley que ha salido del Parlamento Europeo esta semana no incluyen los posibles daños ambientales de los algoritmos en el chequeo de los códigos fuentes aprobado.

Códigos privados

No hay una solución fácil. El internet de los 90 y los primeros 2000 que ofrecía posibilidades de emancipación, libertad y creatividad, se ha convertido, cuando se cumple un cuarto de siglo, en un espacio controlado por pocas empresas que apresan el trabajo vivo y convierten esa creatividad en productos. Hoy, los algoritmos que funcionan con código abierto generan a menudo comunidades que pueden chequearlo y llevar a cabo un examen para prevenir posibles sesgos o deficiencias, pero la experiencia de los últimos años indica que ese trabajo a menudo es atrapado y privatizado por las grandes empresas.

Ekaitz Cancela, autor de Utopías digitales (Verso, 2023) señala en el análisis de la Ley IA que pone en riesgo los modelos abiertos y libres de las universidades y se pone en riesgo a las pequeñas y medianas empresas, “porque para publicar los modelos abiertos tendrán que gastar enormes sumas de dinero en abogados si no quieren tener problemas”. Para este investigador, la norma aprobada no ha reducido el poder de Silicon Valley sino todo lo contrario, al permitir, entre otros aspectos, que las GAFAM extraigan los modelos abiertos para luego privatizarlos.

Scasserra deja una última reflexión: “Yo no estoy segura de que los códigos abiertos sean la solución, probablemente las licencias creative commons sean lo mejor que se puede pensar, pero esa batalla tampoco está ganada, ¿por qué? Porque la IA necesita sistemas de control mucho más holísticos respecto de los impactos y su forma de implementación. Si el debate tratase solo de los sesgos se resolvería muy fácilmente, pero el debate es mucho más amplio y es mucho más complejo”.

Una visión ciberfetichista y utópica nos presenta el futuro con contornos increíbles: planetas enteros diseñados en base a pocos parámetros, una explosión de creatividad y aligeramiento de tareas cotidianas fatigosas. Más tiempo fuera del trabajo, más libertad, en una palabra. La visión tecnoterrorífica pone de relieve la capacidad de destrucción de la humanidad que puede alcanzase aun más fácil o más rápidamente a través de los saltos cuánticos en inteligencia artificial y, como mínimo, un escenario de mayor desigualdad y discriminación. El devenir de la historia de la humanidad en la era del capitalismo señala que una vía es más probable que la otra. Especialmente cuando suenan los tambores de guerra en todo el mundo.